生成AIでのテストコード動作検証レポート

2025年03月19日 10:06

1. 検証の概要

目的: 生成AIを活用したテストコードの動作確認

対象: コードの自動生成と実行結果の評価

背景: 生成AIの進化に伴い、テスト工程の自動化やコード生成の信頼性向上が求められている中で、本検証はその有用性を評価するために実施されました。

この検証では、生成AIによって生成されたテストコードが期待通りの動作をするかどうか、また実際の検証プロセスでどのような結果が得られたのかが重要なポイントとなっています。

以下の条件で検証しました。

■使用した生成AI(無料版)

ChatGPT-4o ⇒本記事はこの内容です。

Claude 3.7 Sonnet (Anthropic)

Gemini 2.0 Flash

Microsoft Copilot

■テスト対象のWebサイト

https://hotel-example-site.takeyaqa.dev/ja/

※Copyright (c) 2020-2025 Takeshi Kishi

■テストシナリオ

① ログイン処理(「メールアドレス」「パスワード」を入力して「ログイン」ボタンを押下する

② 会員登録処理(「メールアドレス」「パスワード」「パスワード(確認)」「氏名」「性別」を入力して登録ボタンを押下する)

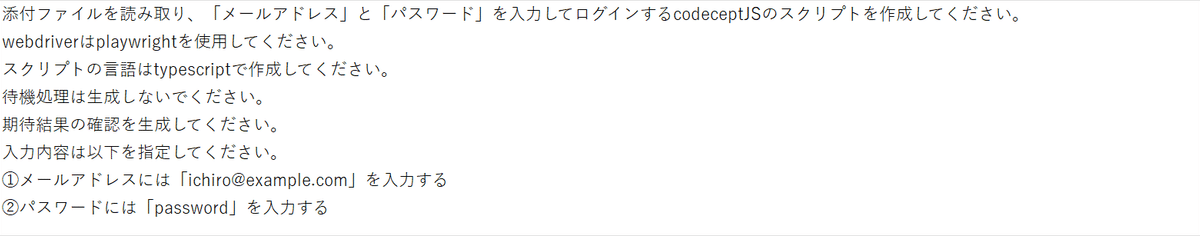

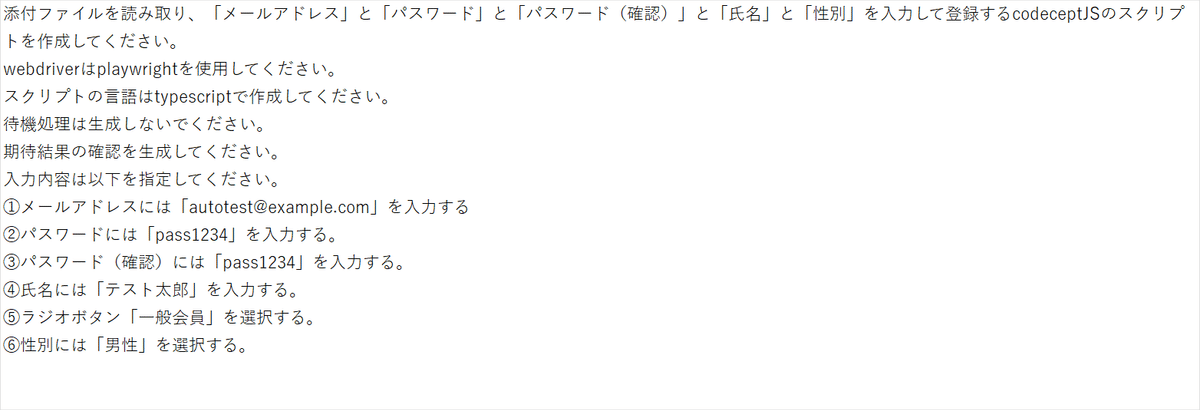

■プロンプト

① ログイン処理自動化生成スクリプト

② 会員登録処理自動化生成スクリプト

2. 検証結果の詳細

■ChatGPT-4oの場合

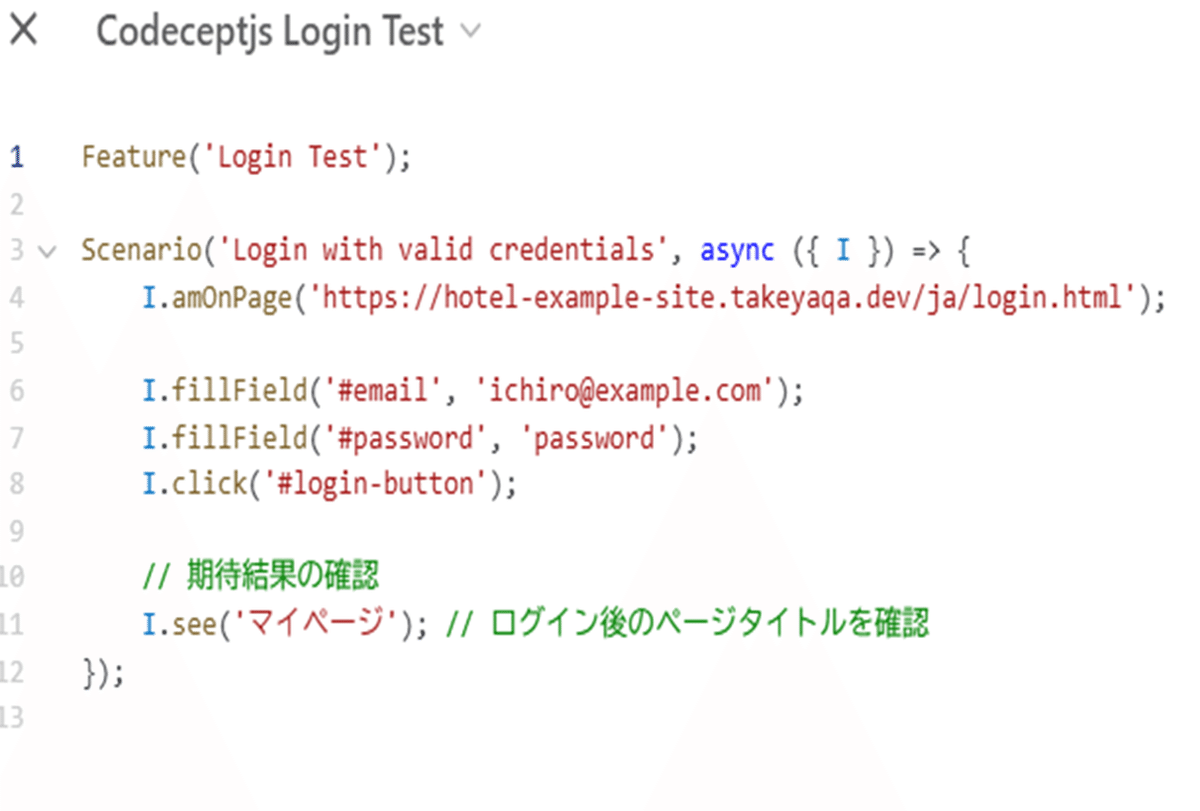

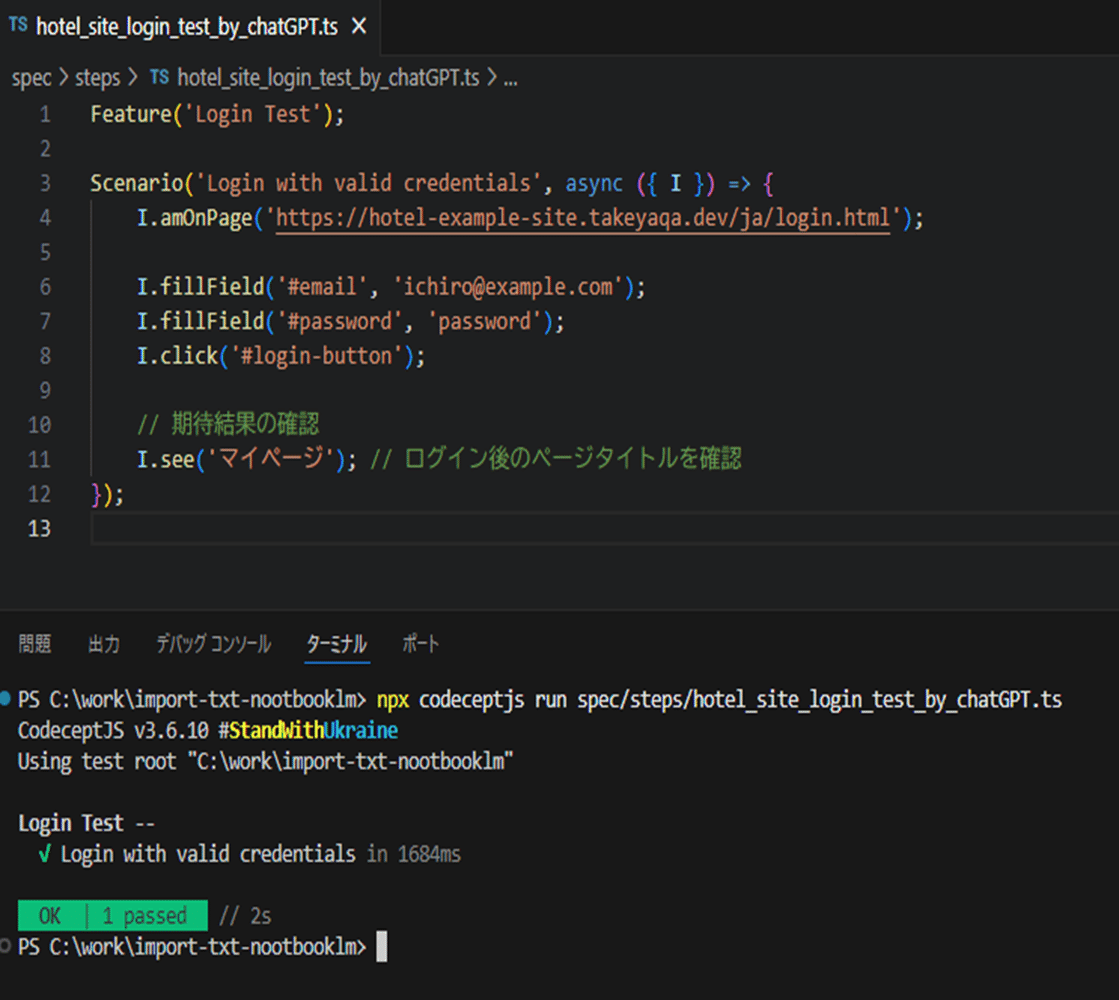

・ログイン処理のテストコード

コメントは少ないが、正しいテストコードが記述されているように見えます。

・動作結果

正常に動作し、結果もOKでした。

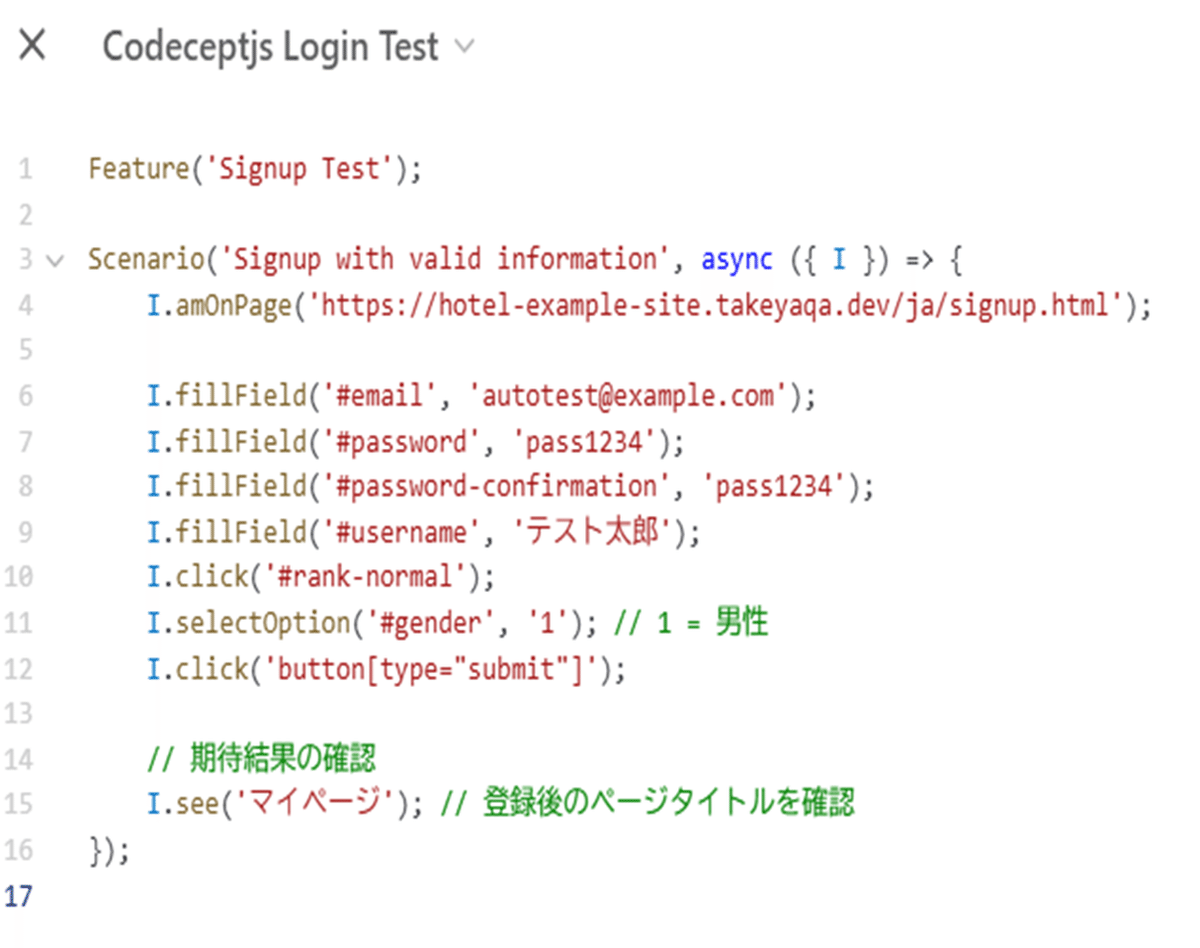

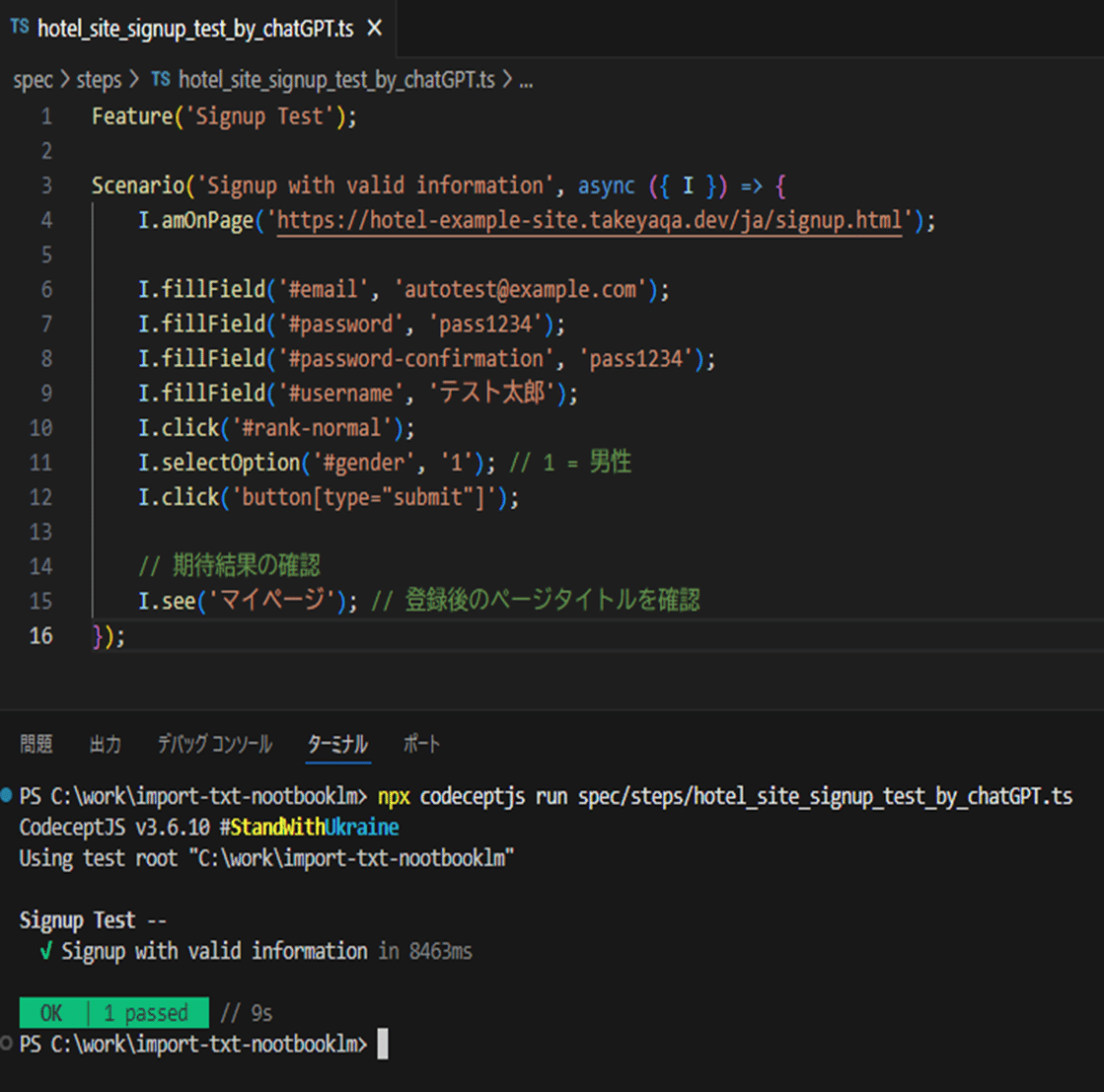

■会員登録処理のテストコード

同じくコメントは少ないが、正しいテストコードが記述されているように見えます。

・動作結果

正常に動作し、結果もOKでした。

3. 結論と今後の展望

今回の検証では、複数の生成AIで自動テストコードを生成し実際に動作させた結果を比較しましたが、ChatGPT-4oだけが一発で正常に動作しました。コードの可読性という意味では他の生成AI(Claude3.7Sonet)の方が高かったのですが、修正が必要なく正常動作したのはChatGPT-4oのみでした。

ChatGPT-4o以外の詳細は割愛しますが、Copilotは修正1回、Claude 3.7 Sonnet は修正5回で正常動作するようになりました。Gemini2.0Flashは、HTMLファイルが読み込めずテストできませんでした。

今回は簡単なテストシナリオで検証しましたが、生成AIのコーディングスキルは実用レベルに近いことが確認できました。ゼロから自分でコーディングするのではなく、最初は生成AIにコードを作らせて修正していく方が、場合によっては効率的かもしれません。

今後は、より高精度なコード生成と、エラーの自動修正機能の実装により、生成AIを活用したテスト工程の自動化がさらに進むことが期待されます。